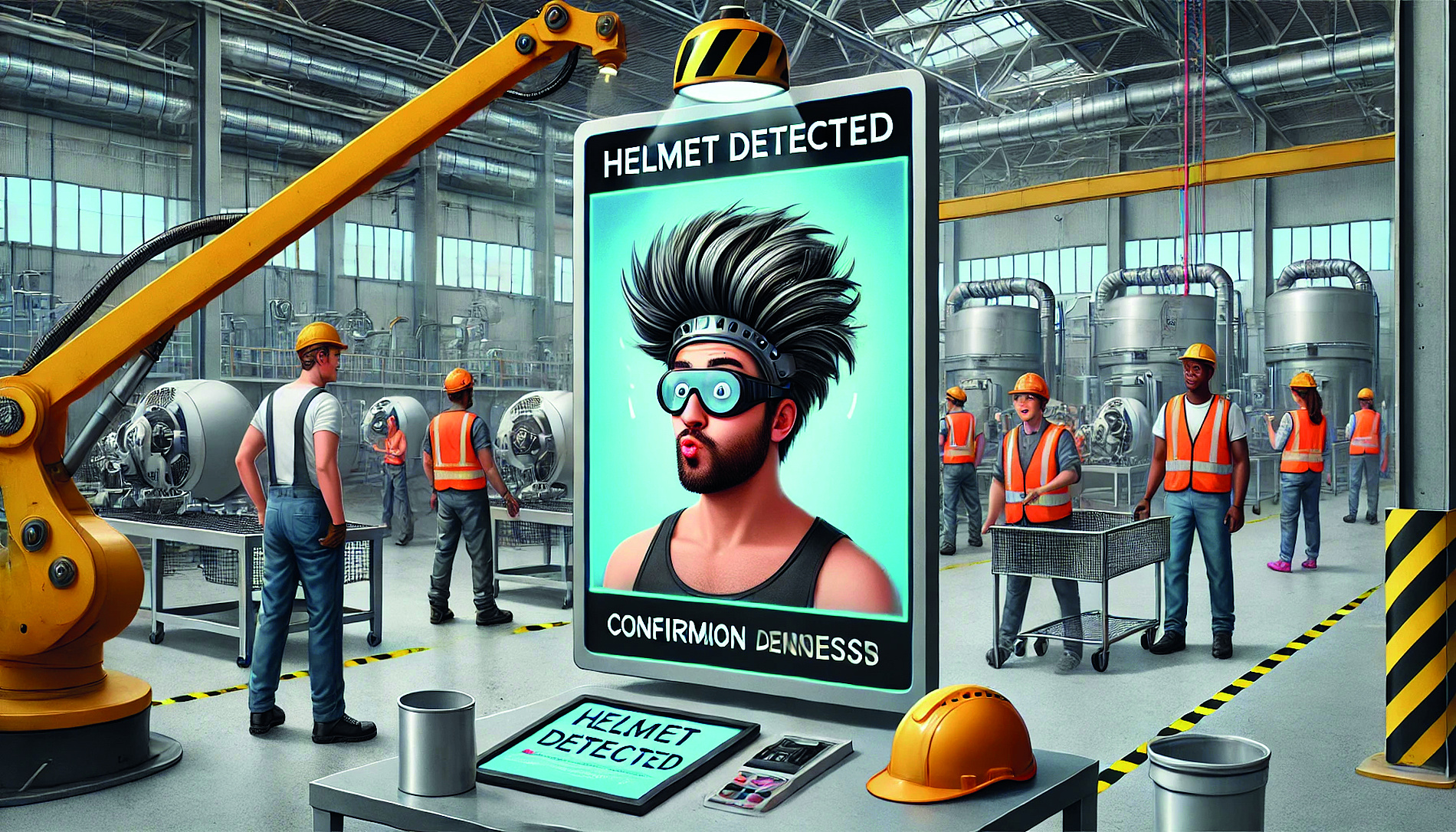

Künstliche Intelligenz kann halluzinieren und Haare als Helme missinterpretieren.

Künstlicher Intelligenz wird in der Regel eine große Zukunft im Wirtschaftsleben zugeschrieben. Doch nach der anfänglichen Euphorie zeigen sich auch die noch bestehenden Schwächen des „Maschine Learnings“ deutlicher. Vor allem das „Halluzinieren“, also Falschantworten und frei erfundene Statements, zählen noch zu den großen Schwachstellen der Künstlichen Intelligenz: Chat-GPT & Co erfinden in ihren Antworten trotz „deep learnings“ plötzlich abenteuerliche Rechenergebnisse, streuen täuschend echt wirkende Erklärungen ein oder setzen beim Schachspiel den Gegner schachmatt, indem sie mit einer Figur ziehen, die sich gar nicht am Brett befindet.

Teure Fehler

„KI-Modelle halluzinieren mitunter auch bei ihrem Einsatz in Fabriken“, sagt auch Michael Haslgrübler. „Wir nennen es nur anders.“ Der Informatiker arbeitet im COMET-Center „Pro2Future“ an Methoden, mit denen Künstliche Intelligenz den Menschen in der Produktion durch Sammeln und Auswerten von Daten unterstützen soll. Dabei kann es durchaus vorkommen, dass KI-Modelle Fehler machen, die nicht nur lästig, sondern unter Umständen auch teuer sind und im schlimmsten Fall auch für Menschen ein Risiko darstellen können.

Besonders deutlich zeigt sich das bei KI-Systemen von der Stange, das heißt bei vortrainierten Systemen, die man sich von Websites downloaden kann, die aber noch nicht auf ihre konkreten Arbeitsumgebungen adaptiert worden sind. In diesem Zustand der KI zählen falsche Antworten mehr oder weniger zum Normalfall: „Da kann es durchaus vorkommen, dass Kopfhaare fälschlicherweise als Sicherheitshelme identifiziert werden“, sagt Haslgrübler – ein Phänomen, von dem sich auch Besucher bei der Langen Nacht der Forschung in Linz selbst überzeugen konnten.

Fatal wäre es, selbst bestens trainierten KI-Modellen die Entscheidungshoheit über das Hoch- und Niederfahren von Produktionsanlagen zu überlassen, etwa in Anlagen für die Zelluloseproduktion, für die Haslgrüblers Team im Projekt REWAI eine KI-Prozesskontrolle entwickelt. Denn obwohl die KI gelernt hat, aus komplexen Mustern von Sensordaten Maschinendefekte frühzeitig zu erkennen: Interpretationsfehler der KI seien nie 100-prozentig auszuschließen, so der Forscher.

„Künstlicher Intelligenz darf in Fabriken nie die Letztentscheidung gegeben werden“, sagt Michael Haslgrübler, COMET-Center „Pro2Future\”

Was also tun?

Für den KI-Einsatz neben Menschen in Fabrikshallen gilt daher, laut Haslgrübler, als Regel Nummer eins: „Einer KI wird nie blind vertraut. Der Mensch behält immer die Letztentscheidung.“ Daraus ergibt sich dann auch schon Regel Nummer zwei: „Die KI muss alle Daten, auf die sie ihre Entscheidung (Alarm! Alarm!) aufbaut, Menschen transparent und nachvollziehbar zur Verfügung stellen“. „Das ist eigentlich so, wie es in Fabriken immer schon war“, meint der Informatiker. „Ein Arbeiter meldete, dass bei einer Maschine irgendetwas nicht stimmt. Der Betriebsleiter geht der Sache nach und fällt dann eine Entscheidung, ob und wie einzugreifen ist.“

Die Konsequenz daraus deutet auf eines hin: Künstliche Intelligenz wird Menschen im Produktionsprozess wohl unterstützen, sie aber nie völlig überflüssig machen. Oder anders formuliert: Nicht alles, was automatisiert werden kann, wird auch automatisiert werden – zu kostspielig, zu unsicher, zu riskant. „Menschenleere Fabriken wird es so also kaum geben.“ Vieles deutet eher darauf hin, dass der KI-Einsatz in der Produktion neue Kooperationsformen zwischen Menschen und Maschinen entstehen lassen wird. Überraschenderweise zeigt sich das auch bei – auf den ersten Blick – recht einfachen manuellen Tätigkeiten. So müssen etwa bei der automatisierten Plastikmülltrennung Arbeiter und Arbeiterinnen am Fließband Müll noch immer nachsortieren, weil die maschinelle Erkennung von Plastikmüllsorten an ihre Grenzen stößt. „Schwierigkeiten bereiten der KI vor allem neue Produkte im Müllstrom“, sagt Haslgrübler. „Neue Formen, Farben und Materialien sind den Maschinen noch unbekannt und werden von ihnen daher auch oft nicht zuverlässig erkannt.“

KI anlernen

Abhilfe schafft nun ein KI-Projekt namens „recAIcle“, das, ebenso wie das REWAI-Projekt, von der Österreichischen Forschungsförderungsgesellschaft FFG unterstützt wird. Der Clou dabei: KI-Modelle schauen den Menschen bei ihrer Arbeit so genau über die Schulter, dass sie hierbei lernen, neue Plastikprodukte zu erkennen. „Menschen am Fließband lernen so die KI an wie neue Mitarbeiter“, erklärt Haslgrübler. Das Überraschende dabei: Der Job des Nachsortierens wird durch die KI nie wegrationalisiert werden, „denn die Produktion neuer Produkte wird es immer geben. Daher wird es auch immer Menschen fürs Nachsortieren brauchen, die die KI trainieren.“

Ob die KI-Einschulung fürs Mülltrennen auch tatsächlich funktioniert, wird nun im „Digital Waste Lab“ in steirischen St. Michael an einer Demonstrationsanlage gemeinsam mit der Montanuniversität Leoben und Siemens Österreich erforscht. Geht alles gut, soll die lernfähige Sortier-KI bald zum Standard in Sortieranlagen zählen. „Das könnte helfen, die Recyclingqoute auf die von der EU geforderten Werte zu erhöhen“, so der Forscher – vorausgesetzt die Sortier-KI beginnt nicht zu halluzinieren.

Lesen Sie diesen Artikel ab Seite 22 der aktuellen Ausgabe 4-24 oder am Austria Kiosk!